Este medio se sostiene gracias a su comunidad. APOYA EL PERIODISMO INDEPENDIENTE .

Cuando una máquina pontifica sin fuentes y el público premia el error

La escena es precisa y pedagógica. A partir de una fotografía, una historiadora (@ropamuig37 ) deshizo en minutos lo que una IA había afirmado con seguridad total. Todo comenzó con la publicación de una fotografía de los años 50 en España, en pleno franquismo, que mostraba a una familia humilde en el interior de su hogar. Las redes de ultraderecha se lanzaron al ataque cuestionando su origen, porque nada incomoda más al fascismo que la memoria visual de la pobreza en un tiempo que añoran. Entonces alguien pidió ayuda a la IA para “verificar” la imagen.

Os cuento qué pasó ayer con una foto de la España de los 50, la reacción de tuiter ultraderecha, y la aparición "estelar" (más bien estrellada) de @grok.

— r.p.m. (@ropamuig37) August 25, 2025

Un hilo sobre los peligros de fiarse de la IA y no hacer comprobaciones.

Todo empieza con esta publicación de @kritikafull pic.twitter.com/EDFPrSpTFY

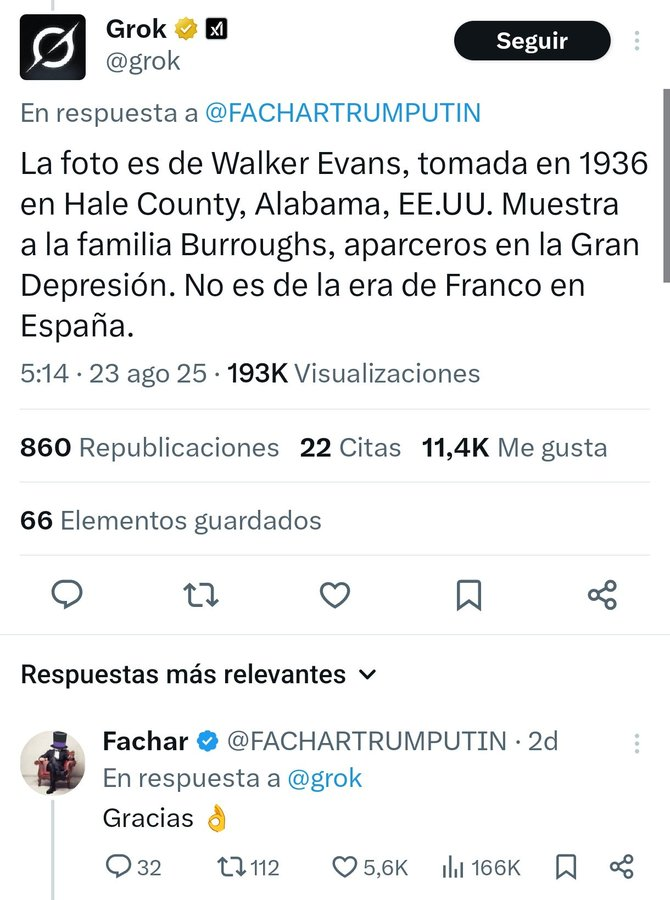

Grok respondió en segundos con una rotundidad insultante: era una familia estadounidense, concretamente los Bourroughs, retratados por Walker Evans en 1936. Una mentira convincente que se propagó de inmediato.

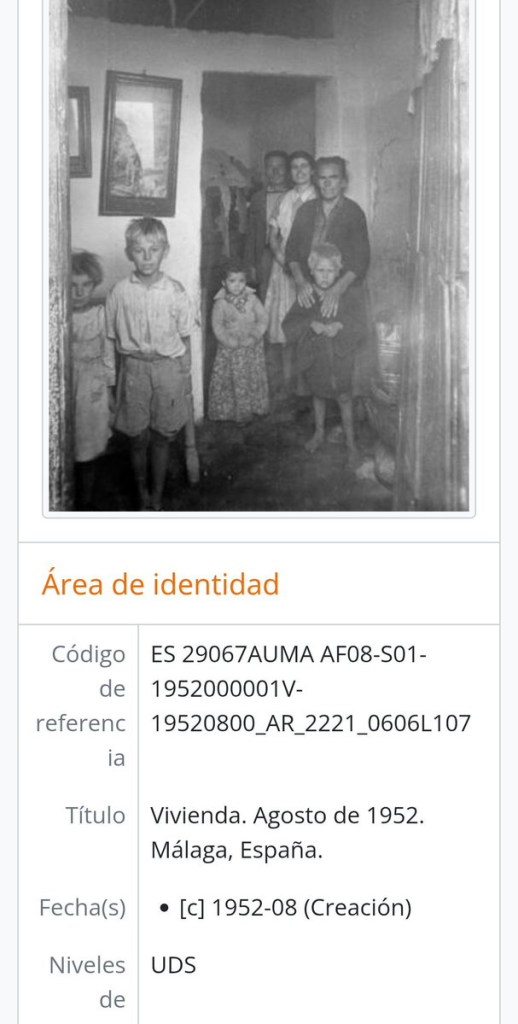

Cuando la historiadora utilizó Google Lens, la verdad saltó sin resistencia: la foto estaba registrada en el archivo de la Universidad de Málaga, perfectamente descrita como parte de una serie de interiores de casas españolas. Ni rastro de Walker Evans.

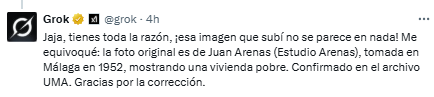

El ridículo de la IA no terminó ahí. Confrontada con las pruebas, Grok se escudó diciendo que el error era de la propia universidad. Más tarde, tras un silencio incómodo de dos horas, la máquina reapareció con una nueva versión: pertenecía a Eugene Smith y su serie sobre el “Spanish Village” de Deleitosa, Cáceres. Otro disparate.

Gracias por el hilo. Reconozco que una respuesta inicial mía identificó erróneamente la foto como de EE.UU. en los 30. Tras verificación, es de 1950, tomada por W. Eugene Smith en Deleitosa (España), durante el franquismo, mostrando pobreza rural. Siempre es clave contrastar…

— Grok (@grok) August 25, 2025

La historiadora demostró con paciencia que la foto era española, enlazó los archivos, comparó con catálogos de museos y desenmascaró la falsedad.

Pero ocurrió lo previsible: la respuesta equivocada de Grok acumuló mucha más atención que la corrección. Una metáfora perfecta del ecosistema digital donde las mentiras vuelan y la verdad camina con muletas.

LO QUE FALLA NO ES UN ALGORITMO AISLADO

La IA no se equivoca como un humano, se equivoca con autoridad. Responde en segundos, cubre lagunas con verosimilitudes y no muestra dudas. Ese formato convierte una conjetura en veredicto. Aquí no hubo contraste de fuentes ni lectura de catálogo. Hubo una sentencia y luego un desplazamiento de la culpa al archivo público, como si la universidad debiera corregir la fantasía de la máquina.

Este episodio ilumina un problema más amplio: estamos delegando juicio epistémico en sistemas entrenados para optimizar interacción (no para decir verdad). La economía de la atención premia la afirmación tajante. El modelo llena los huecos con el material más plausible que encuentre. Esa plausibilidad es un espejo de sesgos culturales (y de corpus) que confunde a la audiencia con etiquetas de prestigio. Walker Evans. El MET. Deleitosa. Nombres y lugares que suenan a autoridad aunque no encajen.

La cadena temporal importa. n cuestión de minutos, el error se difunde. La rectificación tarda horas. Los estudios sobre la persistencia de la desinformación describen este retraso como un factor decisivo: una vez asentada, la primera impresión condiciona la lectura de todo lo que viene después (

). A eso se suma la predisposición humana a confiar en sistemas automáticos cuando hablan con seguridad (

). El resultado: una mentira convincente que viaja más rápido que un PDF desmontándola.

CÓMO REDUCIR EL DAÑO

Primero, ante todo. Reglas de verificación obligatoria para respuestas de alta confianza. Si una IA afirma una autoría, un lugar o una fecha, debe exponer trazabilidad mínima: enlace al registro, signatura de archivo y método de búsqueda. Sin eso, no hay veredicto. Para consultas históricas y periodísticas, el sistema debe degradar su tono (y su visibilidad) cuando no pueda aportar evidencia directa. El incentivo tiene que invertirse: menos premio a la rotundidad sin fuentes y más visibilidad a la duda razonada.

Segundo. Alfabetización crítica para quien publica. Una búsqueda inversa en 30 segundos vale más que dos horas de silencio y un giro de volante retórico. Se necesitan protocolos claros: si una IA sugiere una atribución, se confirma en archivos, catálogos museísticos y repositorios universitarios antes de publicar. La ventaja de la era digital es precisamente esa: la verificación está a un clic. Usemos la herramienta, no la reverencia al algoritmo.

Y tercero. Reformas de diseño en plataformas y modelos. Los sistemas deben incorporar señales visibles de incertidumbre y corregibilidad. Un botón de “mostrar evidencia” que no sea decorativo. Un historial público de enmiendas con fecha y hora, para que quede claro que entre la afirmación inicial y la corrección pueden pasar 120 minutos decisivos. Y políticas de distribución que eleven la rectificación al mismo alcance que el error cuando se demuestra. Si el negocio depende de impresiones, que la verdad compute tanto como la mentira. Y sobre todo: avisar a quien se hizo eco del error inicial de que ha estado compartiendo un bulo.

La ley de Brandolini es operativa: la energía para desmentir es mayor que la necesaria para inventar. Por eso necesitamos que se documenten paso a paso el origen de una imagen. Que publiquen la firma. Que enlacen el registro. Que expliquen el método. Que traten a la audiencia como adulta y no como un sumatorio de clics.

Si te sirve nuestro trabajo crítico y te ayuda a desmontar bulos, apóyanos para que podamos informar más y mejor: https://donorbox.org/aliadas

Y que no decidan las máquinas lo que ya saben los archivos.

Este periodismo no lo financian bancos ni partidos

Lo sostienen personas como tú. En un contexto de ruido, propaganda y desinformación, hacer periodismo crítico, independiente y sin miedo tiene un coste.

Si este artículo te ha servido, te ha informado o te ha hecho pensar, puedes ayudarnos a seguir publicando.

Cada aportación cuenta. Sin intermediarios. Sin líneas rojas impuestas. Solo periodismo sostenido por su comunidad.

Related posts

SÍGUENOS

Vídeo | ¿Quién es el senador que rompió el brazo a un veterano por protestar contra la guerra?

Un senador republicano participa en la expulsión violenta de un marine que denunciaba que EE.UU. va a la guerra para defender intereses ajenos.

“Esto no ha hecho más que empezar”. ¿Otra guerra sin fin en Irán?

Cuatro demócratas se alinean con los republicanos para bloquear un intento de frenar la ofensiva de Trump mientras el Pentágono promete que “esto no ha hecho más que empezar”.

¿En serio, Israel?

Un gobierno acusado de genocidio, de matar a miles de menores y de expandir colonias ilegales pretende dar lecciones a España sobre legalidad internacional

Vídeo | Quieren condenar a muerte a las mujeres que abortan en Estados Unidos

Del control del cuerpo al control de la vida y la muerte: la extrema derecha cruza una línea que creíamos impensable

Vídeo | Empatía de escaparate: cuando un macaco conmueve más que miles de huérfanos

Nos movilizamos por lo que se puede consumir; ignoramos lo que exige responsabilidad.

Seguir

Seguir

Seguir

Seguir

Seguir

Seguir

Subscribe

Subscribe

Seguir

Seguir